Faktabaari näyttää esimerkkien avulla, miten deepfakeiksi epäiltyjen kuvien ja videoiden aitoutta voi yrittää tarkistaa.

Generatiivisen tekoälyn avulla voidaan nykyisin hyvin todentuntuisesti muuttaa ihmisten kasvoja, vartaloa ja ääntä siten, että heidät saadaan tekemään ja sanomaan asioita, joita he eivät todellisuudessa ole koskaan tehneet tai sanoneet.

Tekoälyllä voidaan myös helposti ja nopeasti luoda aitojen valokuvien näköisiä kuvia lähes mistä tahansa aiheesta. Videoihin ja kuviin voidaan lisäksi vaikkapa lisätä esineitä totuuden vääristämiseksi.

Tällaisia tekoälyllä tehtyjä manipulaatioita kutsutaan nimellä deepfake eli suomeksi syväväärennökset.

Taitavasti tehtyjä deepfakeja on nykyisin liki mahdotonta erottaa aidosta materiaalista. Jo vuosikausia etenkin naisia ympäri maailmaa on kiristetty ja häpäisty tekemällä heistä syväväärennettyä pornografista materiaalia, mutta tänä vuonna deepfake-teknologiaa on alettu ahkerasti käyttää myös poliittisessa kamppailussa ja vaaleissa länsimaissa(kin).

Esimerkiksi Slovakian parlamenttivaaleissa syksyllä 2023 deepfake-teknologiaa käytettiin useita kertoja vääristelemään poliitikkojen sanomisia. Eräästä maan kärkipoliitikosta oli muun muassa tehty ääninauha, jossa kuulosti siltä kuin tämä olisi keskustellut toimittajan kanssa vaalien manipuloinnista ja äänten ostamisesta Slovakian romanivähemmistöltä. Todellisuudessa ääninauha oli deepfake-teknologialla tehty.

Yhdysvalloissa Floridan kuvernööri Ron DeSantis joutui syksyllä 2023 deepfaken uhriksi, kun verkossa levisi hänestä tekoälyllä tehty video, jossa DeSantis kertoi luopuvansa presidenttiehdokkuudestaan.

Helmikuussa 2023 Chicagon pormestariehdokkaiden esivaalissa joku puolestaan oli kloonannut ehdokas Paul Vallas’n äänen ja laittanut hänen suuhunsa sanoja niin, että vaikutti siltä kuin Vallas hyväksyisi poliisiväkivallan.

Ja niin edelleen.

Suomikaan ei ole näistä kehityskuluista irrallaan. Täälläkin esimerkiksi poliitikkojen ääniä on jo kloonattu muun muassa Youtubessa ja Tiktokissa julkaistuilla videoilla, joissa on hassuteltu sillä, mitä kaikkea poliitikot voidaan tekoälyn avulla saada sanomaan tai laulamaan.

Huoltovarmuuskeskuksen johtava varautumisasiantuntija Antti Sillanpää onkin arvioinut Suomen Kuvalehdessä, että “hyvin ajoitettu, ajatuksia sekoittava syväväärennös voi vaikuttaa äänestyspäätökseen.”

Samalla on konkretisoitunut myös toinen huoli deepfakeista: se, että myös aitoa materiaalia on alettu syyttää väärennetyksi. Tästäkin on jo lukuisia esimerkkejä - tuore tapaus esimerkiksi Argentiinan vaaleista marraskuulta. Presidentinvaalien toiselle kierrokselle selvinneestä ehdokkaasta, valtiovarainministeri Sergio Massasta, oli kuvattu video, jossa tämä näyttää hyvin väsyneeltä. New York Times -lehti raportoi, että ehdokkaan vastustajat olivat alkaneet väittää videon perusteella, että Massa käyttäisi huumeita. Kannattajat puolestaan iskivät takaisin väitteillä siitä, että kyseessä olisi deepfake.

Massan kampanjatiimi kuitenkin vahvisti, että materiaali oli aitoa, mutta huumeidenkäytön se kiisti.

Sekavaa? Kyllä.

Onko nyt mahdotonta tietää, mikä on totta ja mikä ei? Ei välttämättä.

Faktabaari julkaisee vielä tänä vuonna tekoälyoppaan viime vuonna julkaistun digitaalisen informaatiolukutaidon oppaan jatkoksi. Tekoälyoppaassa tulee olemaan runsaasti tietoa ja pohdintoja tekoälyn hyödyistä, haitoista ja muun muassa siitä, millaisia eettisiä kysymyksiä tekoälyn käyttöön liittyy etenkin koulumaailmassa.

Deepfaket ja niiden tunnistaminen ovat yksi osa tulevan oppaan antia. Seuraavaksi käydään esimerkkien avulla läpi muutamia vinkkejä deepfakejen tarkistamiseen.

Yleispätevinä ohjeina voi sanoa, että:

- Jos jokin somessa vastaan tuleva kuva, video tai ääninauha herättää voimakkaan tunnereaktion, ensimmäiseksi on syytä pysähtyä, harkita ja harkita vielä uudestaan ennen kuin uskoo materiaalia ja jakaa sitä eteenpäin.

- Pohdi kolmea kysymystä: Kuka kuvan/videon/ääninauhan on julkaissut? Mitä todistusaineistoa sen tueksi on esitetty? Mitä muut lähteet sanovat asiasta?

- Käytä lateraalista lukutapaa: Ovatko luotettavat lähteet raportoineet asiasta? Onko joku kyseenalaistanut materiaalin aitouden kommenteissa? Löydätkö muita kuvia/videoita/materiaalia samasta tapahtumasta?

- Ole skeptinen etenkin, jos juuri ennen vaaleja sosiaalisessa mediassa alkaa levitä jokin skandaalinkäryinen kuva/video/ääninauha. Ota tarpeen mukaan yhteyttä viranomaisiin, faktantarkistajiin tai muuhun journalistiseen mediaan.

Tiettyjen yksityiskohtien kanssa generatiivisella tekoälyllä on edelleen usein haasteita. Sen vuoksi:

- Tarkista, ovatko videolla puhuvan ihmisen suun liikkeet ja ääni yhtäaikaiset ja uskottavat.

- Kuulostaako ääninauhalla siltä, että puhuja hengittää välissä? Tulevatko hengitykset loogisissa kohdissa? Entä onko puheessa täytesanoja ja epäröintiä, vai kuulostaako puhe epäilyttävän harkitulta ja suoraviivaiselta?

- Onko puheen intonaatio liian monotonista ollakseen totta?

- Räpsyvätkö puhujan silmät? Entä katsovatko ne samaan suuntaan?

-

Tekoälyllä tehdyissä kuvissa ja videoissa virheitä voi näkyä esimerkiksi käsissä, hampaissa, korvissa, silmälaseissa ja vartalon mittasuhteissa. Ihmisen iho myös usein näyttää liian pehmeältä ollakseen totta. Tarkista ne.

Käytännön vinkit:

-

Käytä hakukonetta

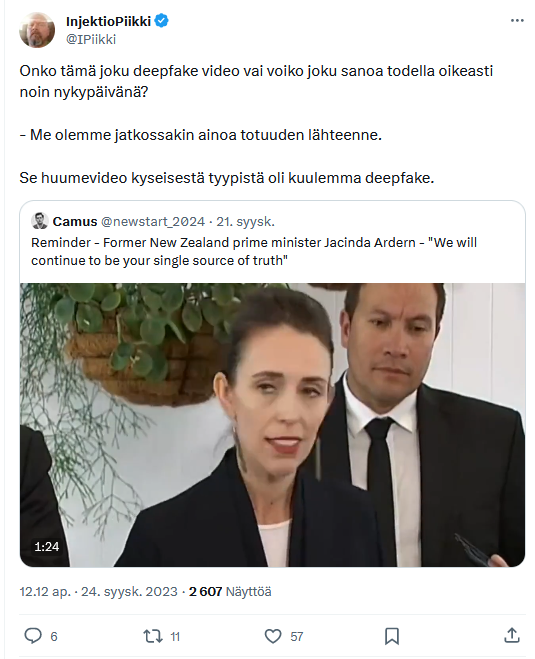

X-viestipalvelussa anonyymi käyttäjä Injektiopiikki on tänä syksynä ihmetellyt, onko Uuden-Seelannin ex-pääministeri Jacinda Ardern todella sanonut, että ”me olemme jatkossakin ainoa totuuden lähteenne”. Videoklippi löytyy X:stä esimerkiksi täältä.

Koska hyvin tehdyt deepfake-videot näyttävät ja kuulostavat nykyisin lähes täysin aidoilta, etenkin huonolaatuisista videoista voi olla välillä vaikeaa sanoa, ovatko ne aitoja vai eivät.

Tässä tapauksessa aitouden tarkistaminen onnistuu kuitenkin perinteisellä Google-haulla. Kirjoittamalla hakukoneeseen Ardernin väitetyn sitaatin ”We will continue to be your single source of truth” sekä nimen “Ardern”, päätyy muutamankin luotettavan lähteen äärelle.

Uuden-Seelannin parlamentin nettisivuille on litteroitu Ardernin parlamentissa pitämä puhe. Parlamentissa syyskuussa 2020 Ardernilta kysyttiin, onko tämä todella sanonut kyseisen lauseen, ja Ardern puheenvuorossaan vahvistaa sanoneensa sen. Ardern on sanonut kyseisen lauseen vuonna 2020 puhuessaan koronapandemian aikana levinneestä harhaanjohtavasta informaatiosta.

Asiasta on tehty myös faktantarkistus, jossa faktantarkistussivusto Snopes päätyy toteamaan saman: kyllä, sitaatti on aito. Myös tämä lähde löytyy kirjoittamalla hakukoneeseen kyseisen sitaatin sitaattimerkkien sisään. Sama Ardernin puhe, mutta eri kuvakulmasta kuvattuna, löytyy esimerkiksi NZHeraldin verkkosivuilta.

-

Käytä arkijärkeä ja tarkista yksityiskohdat

Loka-marraskuussa verkossa on levinnyt hyvin laajalle kuva talvimaisemasta, jossa puiden päälle näyttää kertyneen kauniit symmetriset kinokset. Maiseman on väitetty olevan Suomesta. Viestipalvelu X:ssä kuvan alle kertyneiden satojen kommenttien perusteella moni näyttää luulleen kuvan olevan aito, vaikka todellisuudessa se on tekoälyn luomus. Kuva on julkaistu myös muun muassa Instagramissa, Facebookissa, Pinterestissä ja Quorassa väittäen monissa julkaisuista, että se olisi aito valokuva Suomesta.

Kuitenkin epäilysten pitäisi herätä jo yksinkertaisesti siksi, että kuva näyttää epärealistiselta: etualalla olevan puun latvaan kertyneet kinokset eivät näytä noudattavan fysiikan lakeja. Täysin identtiset lumikinokset näyttävät kummallisilta. Kuvan pehmeys ja sileys myös kielivät tekoälystä: usein tekoälyllä tehdyt kuvat tunnistaa siitä, että ne ovat liian pehmeän näköisiä ollakseen totta.

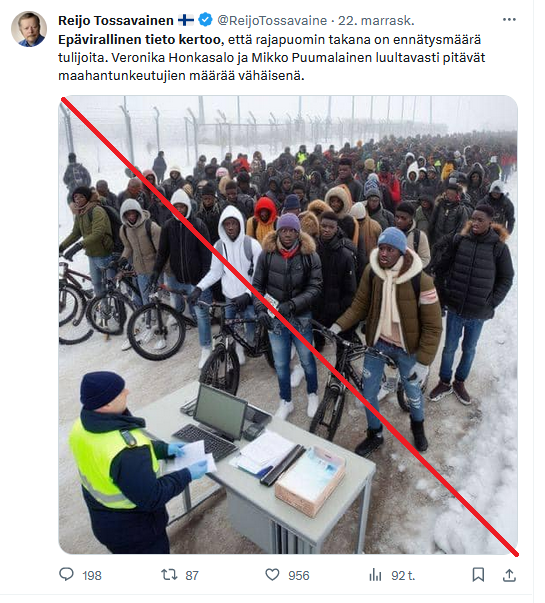

Tekoälysovelluksilla on haasteita tiettyjen yksityiskohtien kanssa, ja kuvien yksityiskohtia onkin siksi syytä tutkia epäilysten herätessä. Yllä olevaa kuvaa on Suomessa levitetty itärajan tilanteen kiristyessä muun muassa viestipalvelu X:ssä sekä Ylilaudalla. Se ei kuitenkaan ole aito vaan vaikuttaa tekoälyllä tehdyltä.

Kuvassa esimerkiksi ihmisten kasvot ovat sameita ja epämuodostuneita, etualalla oleva pöytä näyttää leijuvan, ja kuvan vasemmassa reunassa näkyy ylimääräisiä polkupyörien renkaita. Kuvassa on myös ylimääräisiä kenkiä, ja joidenkin ihmisten jalat ovat muuttuneet osittain läpinäkyviksi.

-

Etsi muita kuvia samasta tapahtumasta

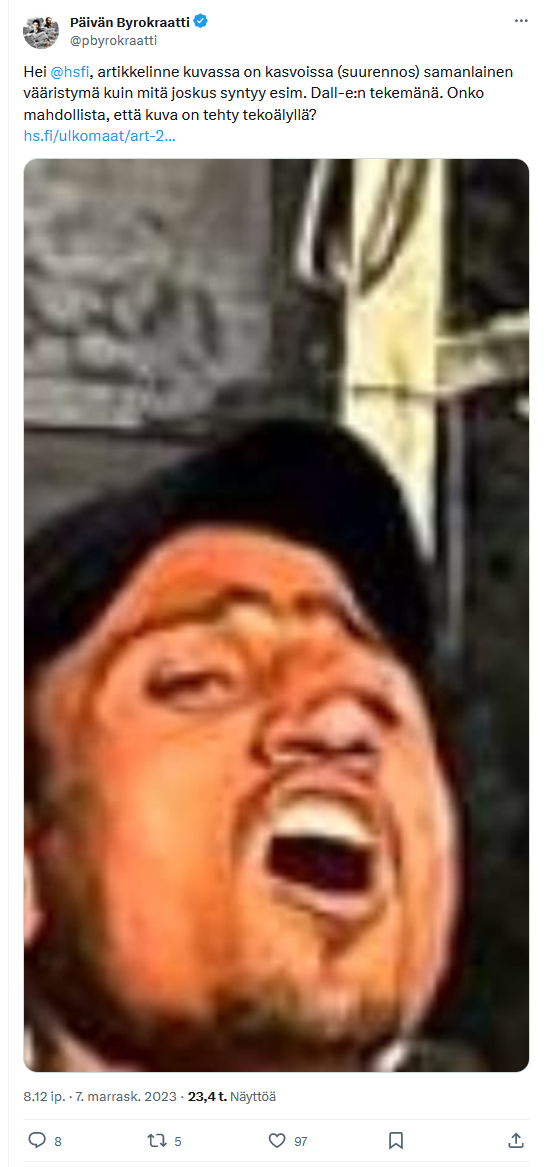

Kuten sanottua, myös aitoa materiaalia on alettu syyttää tekoälyllä tehdyksi. Yllä tästä yksi esimerkki marraskuun alusta. Useampi käyttäjä X-viestipalvelussa väitti tai epäili, että Helsingin Sanomat olisi julkaissut tekoälyllä tehtyjä kuvia Gazasta.

Tämä ei pidä paikkaansa. HS:ssa julkaistut kuvat ovat aitoja. Tähän lopputulokseen osa epäilijöistäkin lopulta päätyi X:ssä.

Tällä kertaa kuvien varmentaminen onnistuu esimerkiksi etsimällä muita kuvia samasta tilanteesta. Näin voi tehdä vaikkapa etsimällä hakukoneesta kuvan ottajan nimellä ”Mutasem Murtaja” ja kirjoittamalla perään esimerkiksi ”man carrying child gaza” tai “gaza city”. Näin löytää Reutersin verkkosivuilta toisen kuvan samasta tilanteesta, sekä muutaman muun kuvan, jotka kuvaaja on selvästi ottanut seisoen samassa kohdassa. Esimerkiksi Le Monde -lehden sivuilla on julkaistu saman valokuvaajan ottama kuva, jossa näkyy sama graffiti, samat puut ja muutoinkin sama maisema kuin Helsingin Sanomien julkaisemassa kuvassa.

Se, että samalta paikalta löytyy useita kuvia, on hyvin varma merkki siitä, että kuva on aito.

Sen sijaan AFP:n hiljattain tekemässä faktantarkistuksessa on esimerkki toisesta kuvasta, jossa mies kantaa lapsia turvaan Gazassa. Tällä kertaa kuva oli tekoälyllä tehty. Sen näkee nopeasti siitä, että kuvassa olevien ihmisten kädet ja jalat näyttävät epärealistisilta ja niitä on liikaa. AFP huomauttaa myös, että käänteisen kuvahaun perusteella kyseistä kuvaa ei ole julkaissut yksikään luotettava uutislähde, vaan se on levinnyt ainoastaan somessa.

Katso Faktabaarin Youtube-video käänteisestä kuvahausta

Yllä olevissa esimerkeissä päästiin täyteen tai lähes täyteen varmuuteen siitä, ovatko kuvat ja videot aitoja vai eivät. On kuitenkin hyvä pitää mielessä se, että välillä tekoälyllä tehdyn materiaalin tunnistaminen on ammattilaisillekin vaikeaa tai liki mahdotonta.

Siksi deepfakejen kohdalla oleellisinta on pysähtyä, harkita, harkita uudestaan ja kysyä itseltään kolme tärkeää kysymystä: Kuka väitteen on esittänyt? Mitä todistusaineistoa sen tueksi on esitetty? Mitä muut lähteet sanovat asiasta?

-