Jos europarlamenttivaalien alla verkossa lähtee leviämään aidon kuuloinen ääninauha, jossa poliitikko puhuu jotakin skandaalinkäryistä, miten voi varmistua siitä, onko ääninauha aito vai tekoälyllä tehty?

Ihmiset ovat tutkitusti huonoja erottamaan tekoälyllä tehdyt ääniväärennökset aidoista ääninauhoista omilla korvillaan. Ääniväärennösten huomaamista vaikeuttaa entisestään se, kun totumme tekoälyääneen myös siksi, että sen käyttö lisääntyy muutoin luotettavissa journalistisissa sisällöissä.

Ratkaisuksi väärennösten tunnistamiseen on povattu tekoälyavusteista tunnistusteknologiaa. Verkko onkin täynnä erilaisia “AI detector tooleja” eli tekoälyn tunnistustyökaluja. Mutta voiko niihin luottaa?

Lyhyesti sanottuna: lähtökohtaisesti ei.

Ääniväärennöksiä käytetään monenlaisen harmin aiheuttamiseen

Etenkin ääniväärennökset herättävät tällä hetkellä huolta, sillä äänenkloonausteknologia on varsin kehittynyttä ja helppokäyttöistä. Suosittuja äänenkloonauspalveluita tällä hetkellä ovat esimerkiksi ElevenLabs, Descript ja Speechify. Erilaisia äänenkloonauspalveluita löytää hakukoneesta satoja. WebOpettaja Esa Riutta on tehnyt Youtubeen suomenkielisen opetusvideon, jossa hän näyttää, miten helppoa oman äänen kloonaaminen on ElevenLabsin työkalulla.

Ääntä kloonaamalla voidaan siis saada kohdehenkilö sanomaan ääninauhalla mitä tahansa – myös sellaisia asioita, joita tämä ei ole koskaan todellisuudessa sanonut.

Tässä muutamia esimerkkejä siitä, millaista sekaannusta ja harmia äänenkloonausteknologialla on viime kuukausina saatu aikaan Suomessa ja maailmalla:

- Yhdysvaltalaisen poliisin ääni oli kloonattu ja hänet oli kloonatulla äänellä saatu sanomaan rasistisia ja antisemitistisiä asioita.

- Yhdysvaltalaiselle syyttäjälle oli soitettu hänen oman poikansa äänellä ja pyydetty maksamaan takuut, jotta poika pääsisi pois tutkintavankeudesta, jonne poika oli valepuhelun mukaan joutunut autokolarin takia. Todellisuudessa poika ei ollut joutunut kolariin eikä tutkintavankeuteen, vaan kyse oli siitä, että huijarit yrittivät saada isältä rahaa huijauspuhelulla

- Tammikuussa 2024 Yhdysvaltain presidentistä Joe Bidenista tehty ääniklooni soitteli New Hampshiren osavaltiossa äänestäjille ja kehotti heitä olemaan äänestämättä esivaaleissa. Tekijä on sittemmin saatu kiinni, ja hän on väittänyt, ettei motiivina ollut vaaleihin vaikuttaminen vaan tietoisuuden lisääminen tekoälyn riskeistä, raportoi uutistoimisto AP.

- Venäjän opposition näkyvimmän kasvon, Aleksei Navalnyin, kuoleman jälkeen verkossa levisi väärennetty ääninauha, jossa Aleksei Navalnyin äiti Ljudmila Navalnaja kuulostaa syyttävän Aleksei Navalnyin puolisoa, Julija Navalnajaa, Navalnyin kuolemasta. Ääninauha levisi Suomessakin.

- Suomessa Kyberturvallisuuskeskus on raportoinut saaneensa tietoonsa tapauksen, jossa organisaation toimitusjohtajan ääntä oli kloonattu ja käytetty ison rahasiirron pyytämiseen.

- Slovakiassa viime syksyn parlamenttivaaleissa oppositiojohtaja Michal Šimečkasta luotiin ääninauha, joka kuulosti siltä kuin tämä aikoisi ostaa ääniä maan romanivähemmistöltä. Todellisuudessa ääninauha oli tekoälyllä tehty. Šimečkan Edistyksellinen Slovakia -puolue hävisi vaalit. Olemme kirjoittaneet tapauksesta aiemmin:

Lue lisää: Näin tarkistat, onko materiaali aitoa vai deepfake

Lisäksi paljon on myös raportoitu tapauksia, joissa on epäselvää, onko ääninauha aito vai ei. Yhdysvalloissa Baltimoressa on esimerkiksi viime aikoina pähkäilty, oliko erään koulun rehtori oikeasti sanonut rasistisia solvauksia, joita verkossa levinneellä ääninauhalla kuullaan, vai oliko kyseessä sittenkin ääniväärennös. Huolestuttavaa on se, jos emme enää usko aidon materiaalin todenperäisyyteen. Siksi on tärkeää pystyä erottelemaan aidot ääninauhat väärennetyistä.

Auttaako tunnistusteknologia?

Faktabaari on jatkuvasti seurannut kansainvälisissä verkostoissaan keskustelua tekoälyn tunnistusteknologian hyödyistä ja haitoista. Yleinen näkemys tällä hetkellä on se, ettei verkossa kaikkien saatavilla olevasta tunnistusteknologiasta ole hyötyä: se välillä leimaa aitoa materiaalia tekoälyllä tehdyksi, eikä aina tunnista tekoälyllä tehtyä materiaalia väärennetyksi.

Se on siis epäluotettavaa. Faktabaari ei siksi suosittele luottamaan tunnistusteknologiaan.

Maaliskuussa 2024 esimerkiksi Poynter-instituutti julkaisi artikkelin, jossa se testasi neljää verkosta avoimesti löytyvää tunnistustyökalua ääniväärennösten tunnistamiseen. Testissä olivat ElevenLabsin Speech Classifier, AI or Not -työkalu, PlayHT sekä DeepFake-O-Meter. Testissä niille syötettiin kopio Joe Bidenin ääniväärennöksestä, josta kerroimme ylempänä.

Lopputulos oli tämä:

- ElevenLabsin mukaan on vain 2% mahdollisuus, että ääninauha on tehty yrityksen työkaluilla tai että se on väärennetty, vaikka edellä mainitussa New Hampshiren tapauksessa tekijä on kertonut tehneensä äänitteen nimenomaan ElevenLabsin ohjelmistolla.

- AI or Not arveli, että ääninauha on luultavasti ihmisen aitoa ääntä.

- PlayHT antoi pelkän virheilmoituksen.

- DeepFake-O-Meter ilmoitti olevansa 69.7% varma, että kyse on tekoälyllä tehdystä ääninauhasta.

Buffalon yliopistossa kehitetty DeepFake-O-Meter oli siis kyseisellä testikerralla kaikkein luotettavin – mutta ei täydellinen sekään.

Jos epäilee törmänneensä ääniväärennökseen, ElevenLabsin työkalu saattaa kuitenkin olla kokeilemisen arvoinen: vaikka sekin tekee virheitä, ElevenLabsin omilla työkaluilla tehdyt ääniväärennökset se saattaa kohtalaisen hyvin tunnistaa. Jonkinlaista osviittaa se saattaa siis antaa - mutta pelkästään sen antamaan arvioon ei pidä sokeasti luottaa.

France24-sivusto havainnollisti hiljattain, mitä haittaa siitä on, jos tekoälyn tunnistustyökaluja käytetään, mutta ne eivät toimi luotettavasti. Sosiaalisessa mediassa ja osittain myös perinteisessä mediassa aiheutui viime lokakuussa valtava sekaannus siitä, kun AI or Not -työkalu väitti, että Israelin puolustusministeriön julkaisema kuva olisi ollut tekoälyllä tehty – vaikka se oli aito kuva.

Mikä siis avuksi?

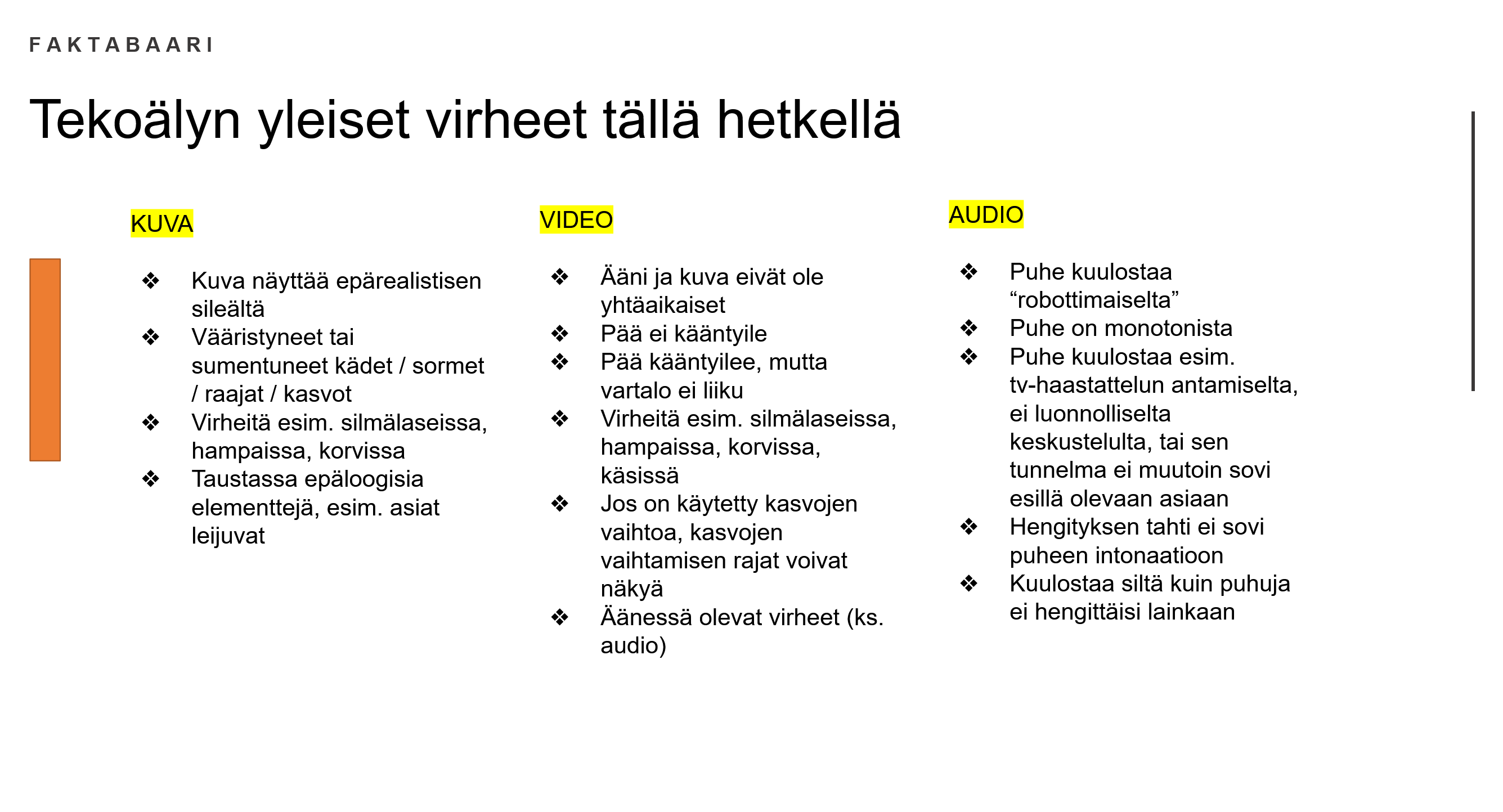

Vaikka tekoälyteknologia, etenkin äänenkloonausteknologia, on jo varsin kehittynyttä, joitain virheitä tekoälyllä tehdyssä materiaalissa saattaa silti edelleen nähdä tai kuulla. Alla tiivistettynä erilaisia tekoälyn tekemiä yleisiä virheitä tällä hetkellä. Näitä kannattaa etsiä, jos epäilee, onko materiaali aitoa vai ei.

Audioväärennösten huomaamisessa auttavat myös nämä vinkit:

- Kun kyse on tunteita herättävästä asiasta (onnettomuus, väitetty laittomuus tms.), niin ihmisellä tunteet kuuluvat yleensä jollain tapaa puheessa, sen rytmin muutoksessa, taukona hätkähdyttävän asian kertomisen jälkeen tms. Audioväärennöksissä vaikeatkin asiat tulevat monotonisena virtana.

- Lisäksi äänisyntetisaattorit tekevät edelleen virheitä esim. nimien ja numeroiden kanssa. Esimerkiksi “äksä-palvelussa” vs “äks-palvelussa” (=X-palvelussa). Tai “500 piste 000 euroa” vs. “viisisataatuhatta euroa” (=500.000 €).

Lisäksi yleinen lähdekriittisyys on tarpeen: Kuka materiaalin on julkaissut? Ketkä sitä levittävät? Miksi se julkaistiin juuri nyt? Onko mahdollista, että kyseessä oleva henkilö voisi oikeasti sanoa jotakin sellaista, mitä ääninauhalla kuullaan? Onko jokin luotettava media raportoinut tapauksesta?

Journalistista mediaa Faktabaari kehottaa viimeistään nyt etsimään jo valmiiksi muutamia asiantuntijoita, jotka voivat tarvittaessa auttaa nopealla aikataululla varmistamaan, onko jokin ääninauha aito vai ei. Mikäli juuri ennen vaaleja verkossa alkaa levitä ääninauha, jossa esimerkiksi joku ehdokkaista sanoo jotakin skandaalinkäryistä, on tärkeää kyetä nopeasti varmentamaan ääninauhan aitous, jotta äänestäjillä on luotettavaa tietoa käytössään äänestyspäätöstä tehdessä.

Faktantarkistajien verkostoissa, esimerkiksi Euroopan digitaalisen median seurantakeskuksessa (EDMO) tällaisia nopeasti apuun saatavia asiantuntijoita on jo kartoitettu. Verkostossa on katsottu, että päätelmän luotettavuus kasvaa, mikäli useampi toisistaan riippumaton asiantuntija päätyy samaan lopputulokseen. Parhaassa tapauksessa asiantuntijat asuvat eri maissa tai ainakin tuntevat julkaisun yhteiskunnallisen kontekstin hyvin.

Yleisenä ohjeena Faktabaari kehottaa lisäksi pitämään tietonsa tekoälyn kehityksestä ajan tasalla. Äärimmäisen tärkeää on lisäksi se, että tekoälyn kehittäjiltä ja digijäteiltä vaaditaan vastuunkantoa ja läpinäkyvyyttä.

Lisää tietoa saa esimerkiksi näistä aineistoista:

Faktabaarin AI-to-pelissä voi testata, erottaako tekoälyllä tehdyn kuvan aidosta kuvasta

Etenkin nuoremmalle kohdeyleisölle hyvän tietoiskun generatiivisesta tekoälystä on tarjoillut tubettaja Ville Mäkipelto. Video löytyy täältä.

Faktabaari järjesti 3.5. ammattijournalisteille pohjoismaisten NORDIS-kollegojensa kanssa EU-vaaleja käsittelevän työpajan, jonka materiaaleja ammattilaiset voivat tiedustella toimitus@faktabaari.fi-osoitteesta.

Artikkelin koostamisessa toimitusta auttoi Faktabaarin taustayhdistyksen Avoin yhteiskunta ry:n hallituksen jäsen, tietokirjailija ja kouluttaja Harto Pönkä.